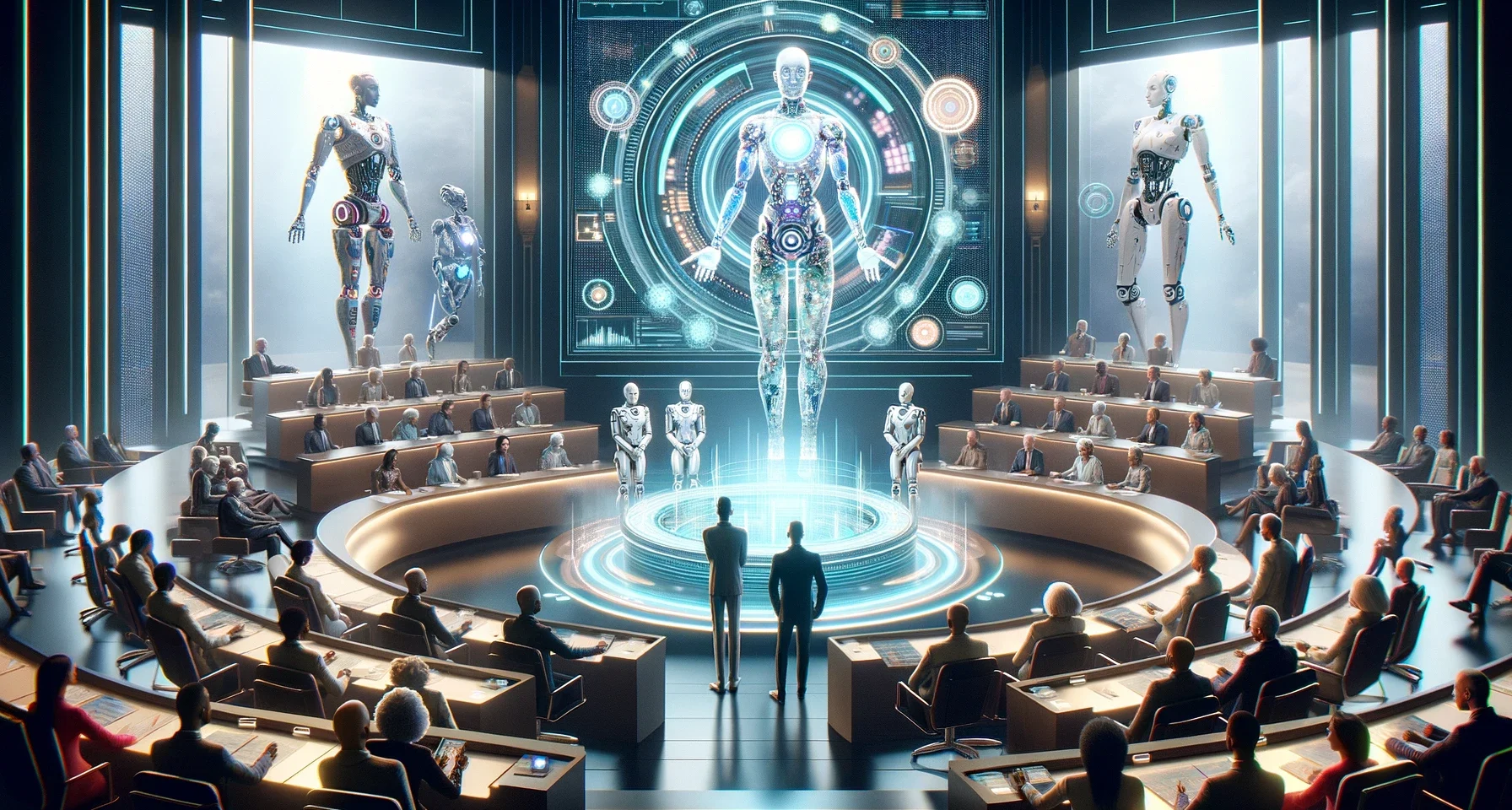

Regulando el futuro: el equilibrio entre innovación en IA y la intervención gubernamental

La regulación de la inteligencia artificial (IA) se ha convertido en un tema crítico en la intersección de la tecnología, la ética y la ley. A medida que la IA se integra más profundamente en aspectos fundamentales de la vida cotidiana, surgen preocupaciones sobre la privacidad, la seguridad, la equidad y la autonomía.

Los gobiernos y las organizaciones internacionales están considerando cómo las políticas pueden guiar el desarrollo y uso responsable de la IA para evitar daños y promover el bienestar social.

Un motivo evidente para regular la IA es la protección de datos personales y la privacidad. Las tecnologías de IA pueden procesar enormes cantidades de datos personales, lo que aumenta el riesgo de violaciones de la privacidad y la seguridad si no se manejan adecuadamente.

Además, la IA plantea preguntas sobre la toma de decisiones automatizada y la transparencia. Los algoritmos pueden perpetuar sesgos existentes o tomar decisiones con consecuencias significativas para las personas sin un proceso claro o justificativo.

Otro aspecto es el impacto en el empleo y la economía. La IA puede desplazar trabajos, creando la necesidad de políticas que aborden la reconversión laboral y la seguridad del empleo.

En cuanto a la urgencia de los gobiernos por regular la IA, uno podría especular que la regulación de la IA también podría ser una herramienta para mantener el control sobre el poder de las grandes empresas tecnológicas y para asegurar la ventaja competitiva nacional en una economía global.

Además, en el ámbito de la seguridad nacional, la IA tiene aplicaciones en el espionaje y la defensa, lo que podría llevar a los gobiernos a proteger ciertos desarrollos como secretos de Estado o a restringir la exportación de tecnologías avanzadas.

Sin embargo, estas especulaciones sobre motivos ocultos requieren un análisis cuidadoso y evidencia concreta. Los llamados a la regulación de la IA se equilibran entre fomentar la innovación y prevenir posibles abusos o consecuencias no deseadas, y es fundamental que este proceso sea transparente y participativo para construir confianza pública en la tecnología emergente.